Dlaczego nasz następny komputer do gier powinien być przenośny?

Laptopowa rewolucja

Biurko. Na nim monitor, klawiatura i myszka. Obok stoi mniej lub bardziej wymyślna obudowa zawierająca podzespoły różne oraz serce komputera – procesor. I kartę graficzną, bo to nasz komputer, do grania, więc musi mieć kartę graficzną. Za biurkiem kłębią się jeszcze klasycznie kable. Znajomy widok? Owszem. Ale odchodzący w przeszłość coraz bardziej. Za jakiś czas, trudno powiedzieć czy będzie to lat kilka czy kilkanaście, stacjonarny komputer będzie takim samym kuriozum jak dziś stacjonarny… telefon.

Można powiedzieć, że PC umiera. I jest to niewątpliwie prawda, jeśli rzeczywiście pod pojęciem peceta rozumiemy właśnie ten powyższy widok. Sprzedaż komputerów spada co roku od ponad dekady, bardzo znacząco, i nie wygląda na to, żeby ten trend miał się kiedykolwiek odwrócić. Dlaczego? To proste – znakomitą większość funkcji naszego „personal computer” przejęły smartfony. Możemy na nich wykonywać prawie wszystkie najważniejsze, najczęstsze czynności, kiedyś zarezerwowane dla PC. Przeglądanie internetu, poczta, Facebook, komunikatory, filmy, seriale – to wszystko mamy w dłoni już, wygodnie, w każdym miejscu, w każdej sytuacji. Nawet gry… ale nie takie gry.

Choć rynek komputerów jako takich kurczy się nieustannie, to segment sprzętu do grania radośnie rośnie. I to w tempie większym, niż zapada się ten ogólny. Prognoza na przyszłość jest jasna – za jakiś czas pozostanie tylko sprzęt biurowy, specjalistyczny, potrzebny na przykład do obróbki grafiki i tym podobnych czynności, oraz, oczywiście, komputer do grania. Tyle, że już nie ten w wielkim, uspokajająco szumiącym, może czasem nawet migającym diodami pudle. Jeszcze dwa, trzy lata temu najlepsi specjaliści, najwięksi znawcy rynku, twierdzili, że laptop nigdy nie zastąpi stacjonarnego komputera do gier. Niewiele wskazywało na to bowiem, żeby coś takiego mogło nastąpić. Owszem, od 2008 roku, kiedy to po raz pierwszy poziom sprzedaży komputerów przenośnych był większy niż sprzedaż desktopów, rosła dysproporcja i na całym świecie kupowano coraz mniej stacjonarnych pecetów. Ale, podobnie jak w powyższym przykładzie dotyczącym ogólnie komputerów osobistych, nie dotyczyło to sprzętu gamingowego. Ten miał się coraz lepiej, mimo zapadania się rynku jako takiego. I tak miało być po wsze czasy. A przynajmniej w najbliższej, możliwej do przewidzenia przyszłości. To znaczy, gdyby nie nastąpiła jakaś rewolucja. Sęk w tym, że nastąpiła.

Laptop do gier? Nie, dziękuję. Nie dość, że wielki, ciężki, głośny i się grzeje, to jeszcze na dodatek jest dużo droższy i, co najważniejsze, ma gorszą kartę graficzną, a co za tym idzie, także ogólną wydajność. Teoretycznie karty w laptopach nazywały się podobnie do tych desktopowych, ale każda z nich miała w oznaczeniu taką małą literkę „M”, która nam mówiła, że mamy do czynienia z mobilną wersją danego układu, przystosowaną do laptopów i… tak średnio o jedną trzecią, a czasem nawet o połowę słabszą, niż podobnie nazywająca się karta włożona do desktopowego pudła. Jasne, były specjalne, najczęściej niedorzecznie drogie laptopy z „prawdziwymi” kartami. Wielkie, ciężkie od układów chłodzących i bardzo głośne, takie, które z przenośnością niewiele miały wspólnego tak naprawdę. Tak było. I, co zabawne, bardzo wielu z nas, graczy, nie zdaje sobie sprawy, że już tak nie jest.

GramTV przedstawia:

A wszystko przez Pascala. Ta architektura procesorów graficznych, następczyni układów Maxwell, będąca sercem kart graficznych z serii GeForce GTX 10, to ten kluczowy nowy krok w trwającej od lat ewolucji, który wywołał rewolucję na rynku. NVIDIA, producent tych układów, od początku dekady stosuje inną politykę projektowania kolejnych generacji swoich kart graficznych. Dawniej najważniejsza była większa moc. I tylko ona. Owszem, każda następna seria GeForce’ów była coraz potężniejsza, ale i wymagała coraz więcej prądu i bardziej wydajnego chłodzenia. Zaczęło się to zmieniać w 2012 roku, gdy zadebiutowały układy Kepler i priorytetem stały się procesy technologiczne prowadzące do miniaturyzacji tranzystorów oraz zwiększenia wydajności energetycznej. Moc rosła, nanometry spadały, w wielkim uproszczeniu. I spadało też zapotrzebowanie procesorów graficznych na prąd oraz wydzielane ciepło. Kiedyś do nowego komputera musieliśmy kupować potężniejszy zasilacz, prawda? Teraz już nie musimy.

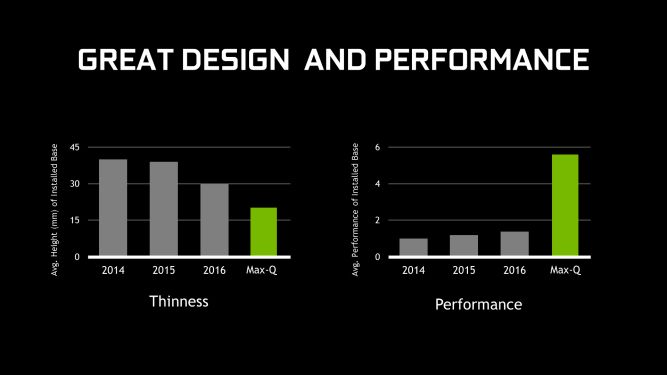

Jak to się jednak ma do rewolucji? Tak, że najnowsza linia GeForce’ów, produkowana w procesie technologicznym 16 nm (a nawet 14 nm w przypadku świeżej serii budżetowych kart GTX 1050), jest już tak wydajna i „chłodna”, że można ją umieszczać w laptopach… bez modyfikacji. Bez tej wywołującej zrezygnowane wzruszenie ramion literki „M” na końcu oznaczenia. Stało się to, co się nie miało stać, co było nie do pomyślenia. Laptopy zaczęły mieć w środku te same układy, co komputery stacjonarne. I, co za tym oczywiście idzie, także tę samą moc i wydajność. Nawet te najcieńsze i najlżejsze, dzięki nowej serii kart od NVIDII, oznaczonych jako Max-Q. Karta Max-Q, czy będzie to topowy GeForce GTX 1080 czy też GTX 1060 dla średniego segmentu, jest zoptymalizowana w kierunku najmniejszego poboru mocy i najmniejszej ilości wydzielania ciepła. Jest dokładnie taka sama pod względem wszystkich parametrów, liczby rdzeni CUDA, jednostek teksturujących i tak dalej, ale ma specjalnie obniżone taktowanie zegarów, więc i mniejsze zapotrzebowanie na prąd. I, według deklaracji producenta, jest tym samym „słabsza” od „normalnego” układu o jakieś 10-15%. Tyle, że w większości testów przekłada się to na zaledwie kilka klatek na sekundę mniej, jeśli chodzi o wyświetlanie grafiki, co w sytuacji, gdy mamy tych klatek nadal w okolicach 50 czy 60, nie robi żadnej zauważalnej różnicy. A nasz komputer przenośny, taki jak nowy Acer Predator Triton 700 czy Asus ROG Zephyrus czy MSI GS65 Stealth Thin, żeby wymienić kilku najbardziej znanych producentów gamingowych laptopów, ma grubość w okolicach 18 milimetrów i waży mniej niż dwa kilogramy. I, często, również zaawansowaną klawiaturę mechaniczną z podświetlaniem każdego klawisza osobno. Oraz matrycę monitora przynajmniej 120 Hz. I, oczywiście, bezszmerowo, bezproblemowo odpala Wiedźmina 3 w 1080p z ustawieniami ultra, czy to na swoim monitorze, czy też na domowym telewizorze, w pełnej glorii tych 50 czy 60 cali.

Ale ile kosztuje?! Jasne, nie jest to sprzęt tani. Podobnie, jak topowe, markowe desktopy. Poza tym, pamiętajmy, że są też „zwykłe” gamingowe laptopy z różnymi GeForce’ami z serii 10, w normalnych cenach. I są to te same karty, co w desktopach, po raz pierwszy w historii. Słychać jej ironiczny śmiech, gdy odwróciły się role, i taki producent jak NVIDIA reklamuje jako nowość właśnie te teoretycznie słabsze karty Max-Q, bo te poprzednie są tak samo potężne, jak karty graficzne w komputerach stacjonarnych. I, co najbardziej zaskakujące, niewiele droższe. A to dlatego, że w sukurs rewolucji gamingowej, która pozwala nam się w końcu wstać z naszym sprzętem od grania od biurka i iść… w sumie gdzie nam się żywnie podoba, przyszły, nieoczekiwanie, kryptowaluty. Od kiedy okazało się, że te mocarne układy GPU, przeznaczone do wyświetlania grafiki w grach z najdrobniejszych detalach, fantastycznie radzą sobie także z szyfrowaniem kryptowalut, kopacze tychże rzucili się na nie jak stado wygłodniałych wilków. Co, oczywiście, spowodowało, według nieubłaganych praw rynkowych podaży i popytu, znaczy wzrost cen tychże układów. A także pojawienie się takich kuriozów, jak karty graficzne… bez wyjść wideo, zbędnych przecież w procesie kopania. I choć możemy się zżymać, że nasz sprzęt do rozrywki zaczął być używany jak prymitywny kilof w kryptowalutowym górnictwie, nie zmienia to sytuacji wcale. Ceny kart graficznych skoczyły. Ale tylko tych desktopowych, przez co stała się druga niesłychana rzecz, po zrównaniu się desktopów i laptopów pod względem mocy – przepaść cenowa także się drastycznie zmniejszyła. Jasne, laptop o porównywalnej wydajności, jeśli chodzi o grafikę i gry, nadal jest droższy. Ale już nie o tysiące złotych, lecz setki. I czy nie warto wyłożyć tych kilka dodatkowych setek? Oczywiście, że warto.

Dawniej laptop do gier miał tak naprawdę tylko jedną przewagę nad komputerem stacjonarnym. Był laptopem. Był przenośny. Można było grać w łóżku, można było grać w podróży, można było podłączyć go do domowego telewizora, można go było zabrać do znajomych i tak dalej. Był cięższy i większy niż normalne laptopy, ale nadal tysiąckroć bardziej mobilny i wygodniejszy niż desktop. Teraz, dzięki nowym GeForce’om, już nie jest cięższy i większy. I jest tak samo mocny, jak stacjonarny pecet. I nadal ma tę wielką zaletę przenośności. I wiele innych, bo NVIDIA od lat usprawnia nie tylko same procesy technologiczne, ale także wprowadza rozwiązania dodatkowe, takie jak chociażby przełomowy G-SYNC, który pozwala dynamiczne dostosowywać odświeżanie monitora do ilości wyświetlanych klatek na sekundę. Albo całkiem świeżą zabawkę, czyli NVIDIA Ansel, która pozwala w dowolnym momencie zatrzymać rozgrywkę i zrobić zrzut ekranu, ale nie z ustalonego punktu widzenia, ale z całkowicie dowolnego, bo możemy dowolnie obracać kamerę. I do tego zapisać screena jako „surówkę”, w gigapikselowej rozdzielczości, jak w najlepszym aparacie fotograficznym, przez co nadaje się on do profesjonalnej obróbki.

Rewolucja nastąpiła. Trochę to smutne, że nasze, wiernie służące nam do grania od dekad desktopy odchodzą w przeszłość. Mamy do nich sentyment, bo związek był długi, owocny i piękny. Tyle, że w końcu wypadałoby się jednak uwolnić od tego biurka, prawda? Największą siłą komputera osobistego była zawsze wszechstronność i uniwersalność. Można było za jego pomocą robić dosłownie wszystko… czyli głównie grać, no wiadomo. Ale tylko w jednym, specjalnie wyznaczonym miejscu. A takie ograniczenie niewiele ma wspólnego z wszechstronnością, prawda? I dziś, tu, teraz, dzięki temu, że NVIDIA produkuje takie same karty graficzne i dla desktopów, i dla laptopów, możemy się w końcu także z tym ograniczeniem rozprawić. I nie będzie nas to kosztowało wiele więcej, po raz pierwszy w historii. Skończyła się pewna era, ale nie ma powodu do smutku, bo ta nowa jest po prostu lepsza. I nasz następny komputer do gier będzie laptopem, z tego prostego powodu, że jest to optymalne, najbardziej rozsądne, najwygodniejsze i pozbawione wad rozwiązanie. Kto by pomyślał, że dożyjemy takich czasów? Cóż, niewielu się tego spodziewało… oprócz inżynierów NVIDII, oczywiście.